OpenAI представила мультимодальную модель GPT-4

Компания OpenAI представила большую мультимодальную модель GPT-4.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

Согласно анонсу, GPT-4 может решать «сложные проблемы с большей точностью благодаря своим более широким общим знаниям и возможностям».

По словам разработчиков, модель может по запросу пользователя принимать ту или иную роль. Например, ее можно попросить стать юристом или репетитором. В таком случае GPT-4 будет точнее обрабатывать запросы, связанные с конкретной областью знаний.

В демонстрационном видео президент OpenAI Грег Брокман показал, как можно научить сервис быстро отвечать на вопросы, связанные с налогообложением.

«Эта модель так хороша в ментальной арифметике. Она обладает широкими и гибкими возможностями», — сказал он.

В OpenAI добавили, что по сравнению с GPT-3.5 новый алгоритм надежнее, креативнее и способен обрабатывать тонкие инструкции.

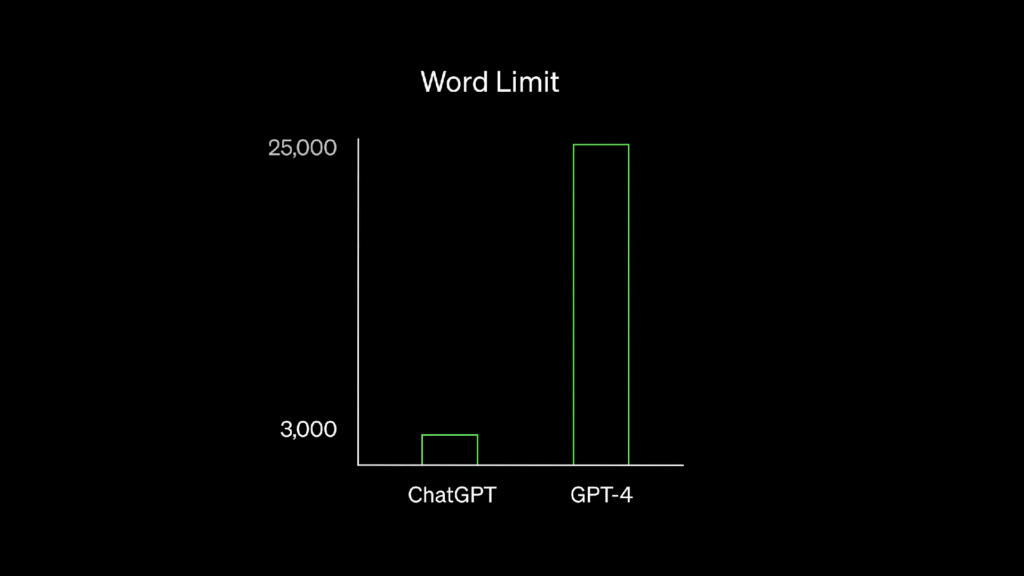

По сравнению с предшественником GPT-4 генерирует значительно более объемнее тексты: 25 000 слов против 3000.

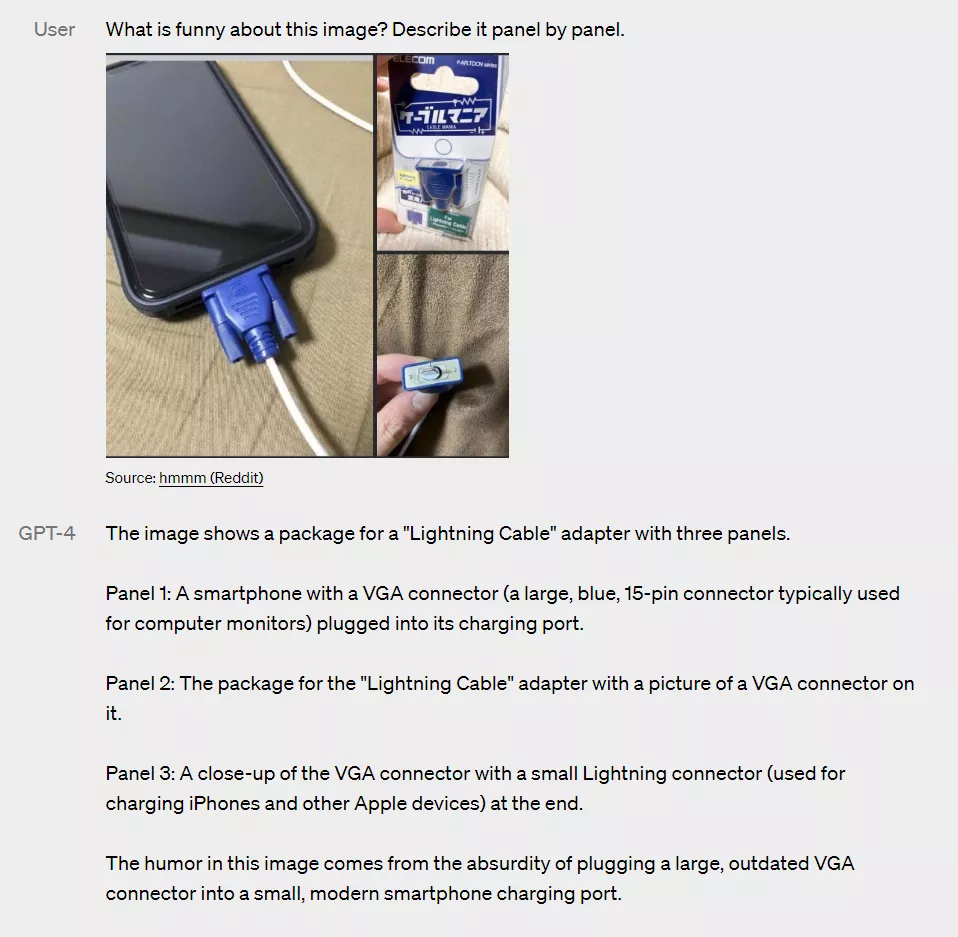

В отдельном видео говорится, что модель обладает рядом возможностей, которых не было у предыдущей версии технологии, включая способность «рассуждать» на основе изображений, загруженных пользователями.

«GPT-4 — это большая мультимодальная модель, которая, хотя и менее функциональна, чем люди во многих реальных сценариях, демонстрирует производительность на уровне человека в различных профессиональных и академических тестах», — говорится в анонсе.

По словам сотрудника OpenAI Андрея Карпати, обработка изображений означает, что ИИ может «видеть».

? GPT-4 is out!!

— Andrej Karpathy (@karpathy) March 14, 2023

— ? it is incredible

— ? it is multimodal (can see)

— ? it is on trend w.r.t. scaling laws

— ? it is deployed on ChatGPT Plus: https://t.co/WptpLYHSCO

— ? watch the developer demo livestream at 1pm: https://t.co/drEkxQMC9H https://t.co/WUYzwyxOqa

Помимо этого, OpenAI выпустила научную работу о GPT-4. Однако разработчики решили не разглашать подробности о размере модели, ходе ее обучения и используемых в рамках этого процесса данных.

Технология доступна подписчикам ChatGPT Plus с некоторыми ограничениями. Компания также открыла список ожидания для желающих воспользоваться API новой модели.

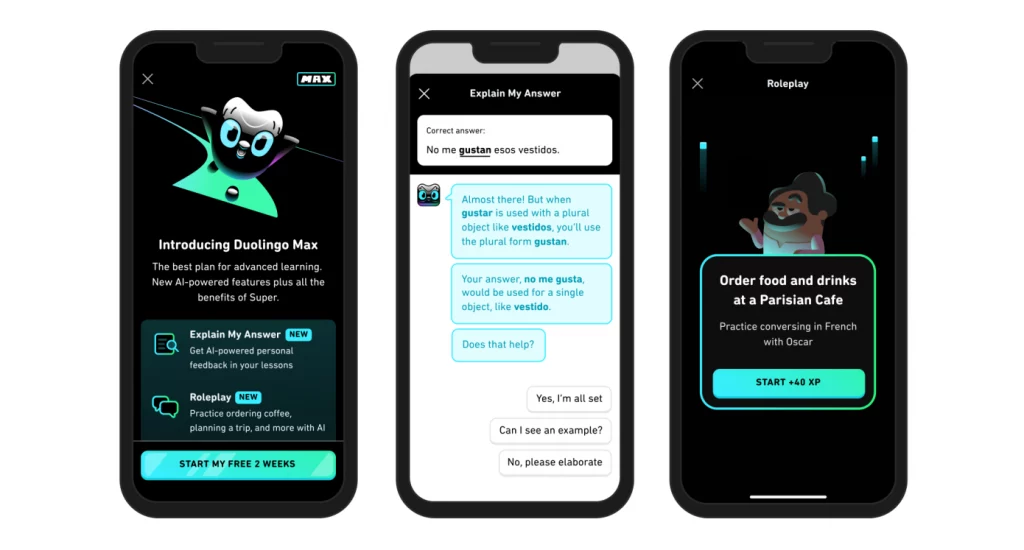

OpenAI сообщила, что уже сотрудничает с некоторыми компаниями над интеграцией алгоритма в их приложения, в том числе с Duolingo, Stripe и Khan Academy.

После анонса Microsoft подтвердила слухи, что новый Bing работает на оптимизированной для поиска версии GPT-4.

Напомним, в ноябре 2022 года OpenAI представила ChatGPT. За два месяца сервис стал самым быстрорастущим в истории, достигнув 100 млн активных пользователей.

В феврале 2023 года Microsoft выпустила обновленный поисковик Bing на базе ChatGPT.

В марте число активных пользователей сервиса превысило 100 млн.

Рассылки ForkLog: держите руку на пульсе биткоин-индустрии!