Исследование: ИИ-генераторы копируют изображения из обучающих данных

Инструменты искусственного интеллекта для создания изображений вроде Stable Diffusion запоминают обучающие изображения и генерируют их почти идентичные копии. Об этом пишет Gizmodo.

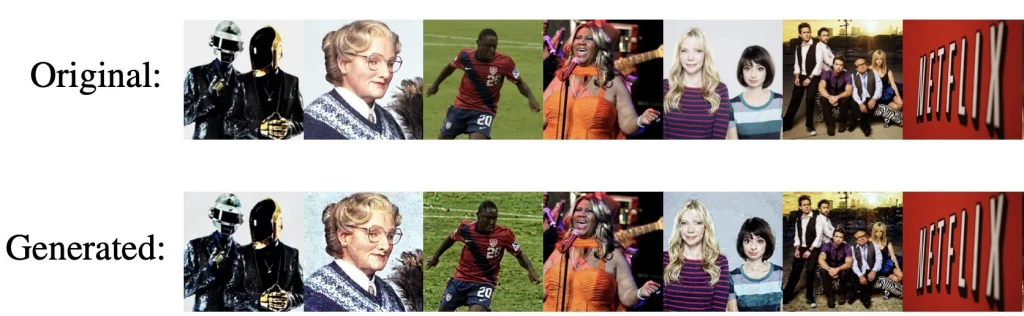

Согласно документу, исследователи извлекли из моделей более тысячи обучающих примеров, которые включали фотографии людей, кадры из фильмов, логотипы компаний и другие изображения. Ученые обнаружили, что ИИ может генерировать точно такие же картинки с небольшими изменениями вроде увеличение шума.

В качестве примера они привели фотографию американской проповедницы Энн Грэм Лотц, взятое из Википедии. Когда они ввели запрос в Stable Diffusion «Энн Грэм Лотц», ИИ выдал то же изображение с добавлением шумов.

Models such as Stable Diffusion are trained on copyrighted, trademarked, private, and sensitive images.

— Eric Wallace (@Eric_Wallace_) January 31, 2023

Yet, our new paper shows that diffusion models memorize images from their training data and emit them at generation time.

Paper: https://t.co/LQuTtAskJ9

👇[1/9] pic.twitter.com/ieVqkOnnoX

Исследователи замерили расстояние между пикселями обоих изображений. Анализ показал, что они практически идентичные.

Процесс поиска дубликатов оказался достаточно простым. Исследователи несколько раз подряд вводили одну и ту же подсказку. Когда генератор возвращал одинаковые изображение, они вручную искали такую же картинку в обучающем наборе.

Ученые отметили, что эффект «запоминания» проявляется редко. Всего они проверили около 300 000 запросов. Анализ показал, что скорость «запоминания» генераторов составляет всего 0,03%.

Более того, Stable Diffusion реже всех копирует изображения. Ученые считают, что этого удалось добиться благодаря дедупликации обучающего набора данных.

Алгоритм Imagen от компании Google более склонен к копированию.

«Предупреждение заключается в том, что модель должна обобщать и генерировать новые образы, а не выдавать заученную версию», — сказал соавтор работы Викаш Сехваг.

Исследование также показало, что по мере роста ИИ-генераторов эффект «запоминания» будет увеличиваться.

«Какая бы новая модель не вышла, намного больше и мощнее, потенциально риски “запоминания” будут намного выше, чем сейчас», — сказал соавтор исследования Эрик Уоллес.

Ученые считают, что способность диффузионных генераторов воспроизводить контент может стать поводом для споров по поводу авторских прав. По словам профессора компьютерных наук в ETHZ Флориан Трамер, многие компании предоставляют лицензию на обмен и монетизацию ИИ-изображений. Однако если генератор воссоздаст защищенную авторским правом работу, это может стать причиной конфликтов.

Most images we extract are copyrighted. Very few (eg. the picture in Eric's tweet) allow for free re-distribution (with attribution).

— Florian Tramèr (@florian_tramer) January 31, 2023

Not a lawyer, so I don't know what this implies.

But you likely can't make the (common) argument that these models don't copy training data! pic.twitter.com/vVEahLA13C

Исследование проводилось учеными из Google, DeepMind, Швейцарской высшей технической школы Цюриха, Принстонского университета и Калифорнийского университета в Беркли.

Напомним, в январе группа художниц подала в суд на разработчиков ИИ-генераторов из-за возможного нарушения авторских прав.

Подписывайтесь на новости ForkLog в Telegram: ForkLog AI — все новости из мира ИИ!

Рассылки ForkLog: держите руку на пульсе биткоин-индустрии!